Bonjour,

Suite à notre intervention voici ci-après un résumé des travaux entrepris et de l’état actuel de l’infrastructure.

Pour rappel, nous voulions faire/préparer la migration de notre Proxmox actuel sur un nouveau serveur plus puissant, migrer le jour-même si possible, pour pallier aux erreurs S.M.A.R.T. de notre serveur vieillissant qui consomme beaucoup d’électricité pour ce qu’il rend comme travail. Voir la news Maintenance samedi 13 juillet sur notre site web.

Dans les grandes lignes, cela ne s’est pas passé comme prévu, une carte RAID qui gère les disques n’est pas capable de laisser les disques sans faire de RAID matériel, ce qui est embêtant selon ce que nous avions prévu comme installation (avoir un système de fichier géré par ZFS).

Maximiser les performances des nouvelles machines

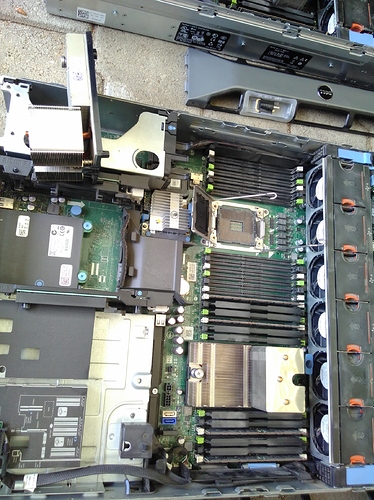

Démontage des serveurs actuels (4 serveurs, 2 baies de disques) pour composer deux serveurs avec une grande capacité, nous avons donc pu faire:

- Deux machines Dell PowerEdge R720xd 2U

- 64 Go de RAM chacune

- 20 To de stockage chacune

- 2 CPU 4 cores à 2 Ghz chacune

Ces machines n’ont pas été obtenue à titre gratuit, nous devons donner la somme que nous pouvons à son ancien propriétaire (on peut donner le nom en privé, demande sur info@swissn…), vu le coût des machines de base et la capacité qu’elles ont cela est justifié.

Pour rappel, nous avons le matériel suivant:

- 2x Dell R720 (qui avaient 2 CPU, 64 Go de RAM, 2x 160 GB de disque)

- 2x Dell R720xd (qui avaient 1 CPU, 10x 2 To de disques + 2x 160 GB, 32 Go RAM)

- 2x Dell PowerVault MD3200

Dépoussiérage

Cette étape s’est faite en partie avec la première selon les composants à installer pour bien nettoyer les slots, toutes les machines sont propres sans poussière désormais. Ces serveurs ayant fonctionné durant 5 ans et demi dans un endroit subissant la poussière.

Chaque ventilateur, disque, etc a été sorti pour nettoyage, d’une part pour améliorer leur durée de vie, et aussi pour ne pas ramener de poussière dans le centre de données.

Tests de fonctionnement

Nous avions pris écran/clavier/souris pour mettre en service les machines, notre but était d’installer Proxmox sur les deux, nous avons fait le tour des paramètres disponibles dans le BIOS, sur la carte RAID et un petit peu l’iDRAC (carte de management du serveur), nous n’avons rien trouvé de particulier.

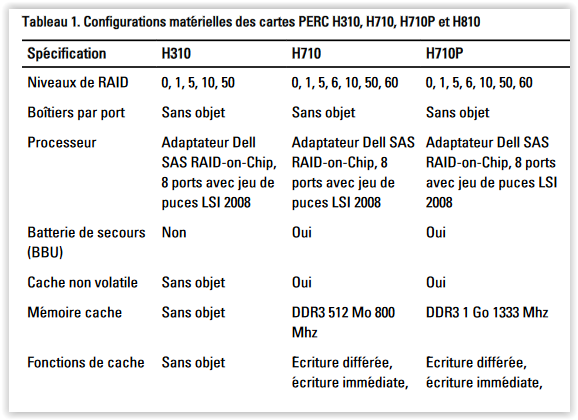

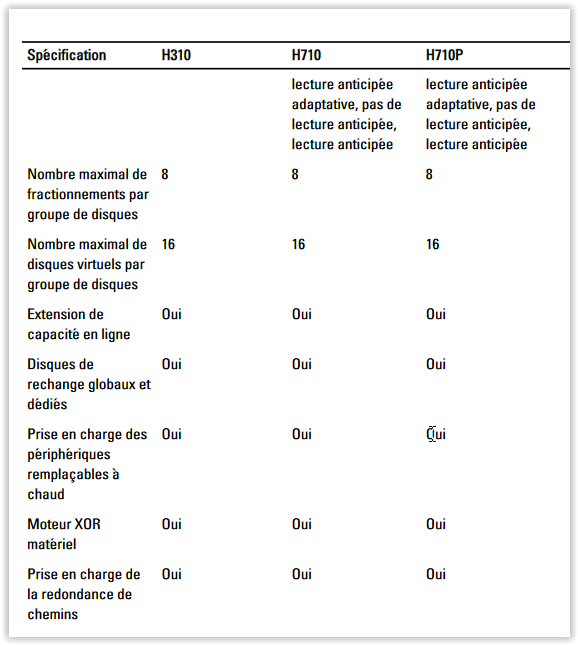

Le problème du contrôleur RAID

Nous souhaitions installer le système de fichier ZFS, qui doit avoir un accès direct aux disques, et le contrôleur RAID des quatre serveurs ne permettent pas d’avoir un accès direct aux disques (pass-through) ce qui est très recommandé pour ZFS, après plusieurs recherches chronophages nous avons abandonné et décidé d’aller installer les serveurs au centre de données et de prévoir une nouvelle journée d’intervention, où nous réglerons ce problème soit par changement de la carte RAID, par changement de firmware ou autre solution proposée par des personnes du domaine que nous consulterons.

Nous avons eu un avis en fin de journée d’une connaissance qui nous a indiqué que le fait de faire un Virtual Disk avec un RAID0 par disque est faisable pour ZFS, et qu’il faut faire une manip en cas de changement de disque, nous vérifierons cela, en étudiant les possibilités évoquées plus haut.

La carte RAID est une Dell PERC H710 qui est rebrandée, à l’origine c’est une LSI MegaRAID SAS 9266-8i.

Départ au datacenter

Nous avons amené les deux machines au datacenter, la mise en place dans la baie s’est faite très simplement, les rails de fixation de la bête sont très pratiques, nous avons posé les machines sur les rails et c’était fait.

Nous avons également installé un switch HP Gigabit 24 ports, où nous prévoyons de l’utiliser pour diviser notre infrastructure en plusieurs réseaux logiques (VLAN) par port physique, ce qui est déjà le cas de manière virtualisée, mais en prenant en compte l’extension pour les CHATONS et FairSocialNet.

Moment de pause

Nous avons pris du temps hors du datacenter, qui est somme toute assez bruyant, pour réfléchir et être hors du bruit de toutes les machines qui tournent dans le centre, pour faire la liste des choses qui nous reste à faire:

- Refaire la pâte thermique des processeurs, après 5 ans et demi de fonctionnement elle est usée.

- Prendre des câbles patch de 1.5m blindé (S-FTP). Actuellement on utilise des câbles de marque R&M qui sont de très bonne qualité.

- Trouver une solution pour mettre le contrôleur de disques en bypass/pass-through.

- Installer Proxmox sur chaque machine et les mettre en cluster.

- Configurer le switch et les VLAN.

- Configurer les backups locaux (les backups distants fonctionnent déjà, ils sont chez Jojo).

- Trouver un moyen de réveiller/allumer le serveur à distance, possiblement en Wake-on-LAN ou via l’iDRAC.

- Donner un badge d’accès à un troisième sysadmin, en coordination avec Nimag.

- Edit: Support de câbles pour l’arrière des serveurs à récupérer

La suite

Afin de continuer cette migration, nous prévoyons une nouvelle journée d’intervention quand nous aurons pu réunir et préparer tous les éléments ci-dessus, nous proposons aux personnes intéressées/participant·e·s à l’infrastructure d’être présent ce jour-là, qui devrait, si possible, être le samedi 27 juillet toute la journée.